Teil 2: Der Weg zur Cloud

Der Weg zur Cloud

Bisher dominierten grundsätzlich zwei Modelle die Datenverarbeitung. Die Verarbeitung von Daten mit Großrechnern in Rechenzentren ist dabei die älteste Variante. Hier wurden die Berechnungen zentral von speziellem Personal durchgeführt. Diese Systeme kamen hauptsächlich in der Wissenschaft und in großen Verwaltungen zum Einsatz.

Client-Server Struktur

Client-Server Struktur

Das nächste Modell ist die Client-Server-Architektur, bei der mehrere Rechner über einen Server miteinander verbunden sind. Hierbei greifen zum Beispiel mehrere Clients auf eine zentrale Datenbank im lokalen Netzwerk zu.

Als weiterer Entwicklungsschritt ist nun das Cloud-Computing dazugekommen. Anwendungen werden nicht mehr lokal ausgeführt und Daten nicht mehr lokal gespeichert. Sowohl die Ausführung der Anwendung als auch die Speicherung der Daten wird auf externe Infrastrukturen ausgelagert. Die dafür verwendeten Technologien sind nicht neu, aber deren Nutzung beschreitet einen neuen Weg. Zum Beispiel verwenden Webanwendungen ähnliche Prinzipien wie sie beim Cloud-Computing Einsatz finden und stellen dem Nutzer verborgene Leistung zur Verfügung.

Allerdings agiert Cloud-Computing nicht nur im Bereich von Anwendungen, sondern vor allem auch auf der Ebene von Daten und Rechenleistung. So betreibt zum Beispiel Dropbox eigene Server für die Website und die Verwaltung der Benutzer, benutzt aber für die Speicherung der großen Datenmengen den Cloud-Service S3 von Amazon.

Geschwindigkeit für die Cloud

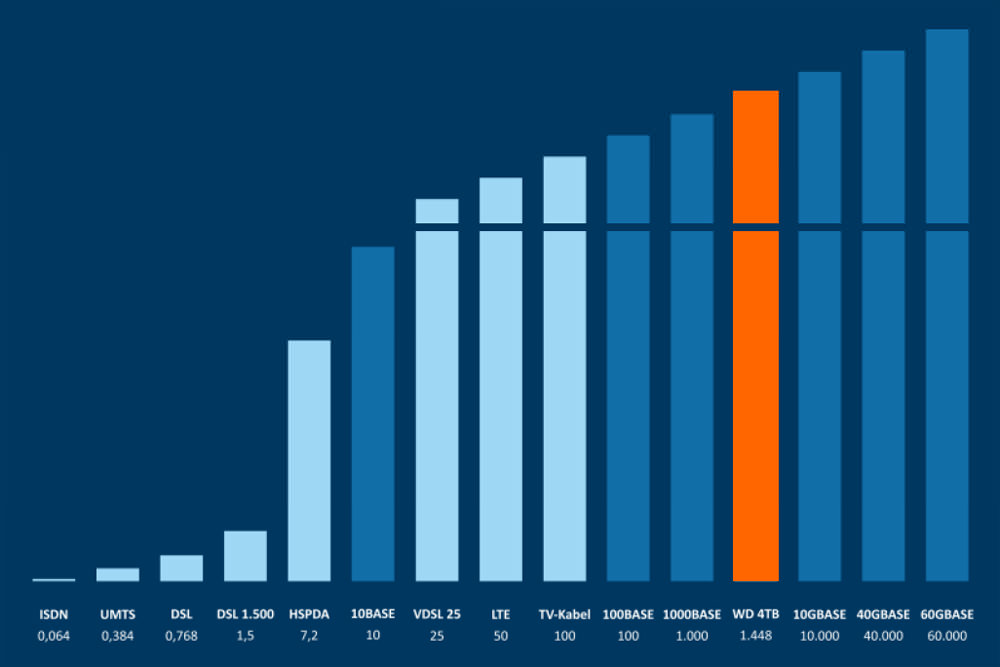

Netzwerk-Geschwindigkeit im Vergleich mit einer Festplatte

Netzwerk-Geschwindigkeit im Vergleich mit einer Festplatte

Erst die Weiterentwicklung und Ausbau der Internetbandbreite ermöglichte die Entwicklung und Nutzung von Cloud-Computing. Umso größer die Geschwindigkeit, desto komplexere Leistungen können über das Internet angeboten werden. Der ehemalige CEO von Google, Eric Schmid, hatte schon 1993 während seiner Zeit bei SUN diese Entwicklung beschrieben: „Wenn das Netzwerk so schnell wie der Prozessor wird, wird der Computer ausgehöhlt und über das Netzwerk verteilt.”

Ende der 90er-Jahre erfolgte mit dem Dotcom-Boom der großflächige Ausbau der Netzbandbreite. Modems wurden immer schneller und der ISDN-Anschluss wurde eingeführt. Die Rechenzentren wurden untereinander mit Glasfaserverbindungen vernetzt und die gesamte Netzwerkinfrastruktur wurde immer schneller.

Nach der Jahrtausendwende etablierte sich der DSL-Breitbandanschluss immer mehr und machte so eine schnelle Verbindung in vielen Bereichen verfügbar. Mittlerweile sind bis zu 100 MBit/s Internetanschlüsse über das Fernsehkabel verfügbar und haben damit die lokale Netzwerkgeschwindigkeit erreicht, die noch vor ein paar Jahren Standard war.

Der nächste Schritt in der globalen Vernetzung ist der Glasfaseranschluss für private Nutzer. Die Telekom hat mittlerweile die Liste mit Städten veröffentlicht, in denen das Fiber-To-The-Home-Netz mit einer Geschwindigkeit von 200 MBit/s im Downstream und 100 MBit/s im Upstream starten wird. Und Google hat selbst in den USA ein Glasfaser-Angebot mit einer Geschwindigkeit von 1 GBit/s gestartet. In London startet der britische Kabelnetzbetreiber Virgin Media einen Versuch für Anschlüsse mit einer Übertragungsrate von 1,5 GBit/s. Damit hat die Geschwindigkeit des Internets eine Schwelle erreicht mit der sie mit lokalen Netzwerken gleichziehen kann.

Im nächsten Teil “Arten und Ebenen von Clouds” werden die unterschiedlichen Definitionen der Arten und Ebenen der Clouds näher betrachtet.

Dieser Blogbeitrag ist Teil der Artikelserie “Sicherheit in der Wolke”.

Hier geht es zu den anderen Teilen:

Teil 1: Was ist Cloud-Computing?

Teil 2: Der Weg zur Cloud

Teil 3: Arten und Ebenen von Clouds

Teil 4: Vor- und Nachteile der Cloud

Teil 5: Sicherheit und Cloud-Computing

Teil 6: Gefahren beim Cloud-Computing

Teil 7: Der Konflikt mit dem Datenschutz

Teil 8: Zusammenfassung

Bild-Quelle: SXC